Hoe krijg je een succesvol dashboard?: Requirements & Storytelling

Hoewel het essentieel is, is de waarde die jouw dashboard kan bereiken niet volledig afhankelijk van de gegevens die je beschikbaar hebt. Het is net zo belangrijk worden om het verhaal achter je gegevens op de meest efficiënte manier mogelijk te laten zien, terwijl je kritisch het publiek en het doel van jouw dashboard beoordeelt. Een gebrek aan focus op die basisprincipes kan resulteren in een overvloed aan rapporten die zijn gemaakt zonder dat er goed rekening is gehouden met de behoeften van het bedrijf.

Doelgroepen worden overspoeld met doelloze dashboards die niet de vereiste inzichten tonen. Uiteindelijk hebben dashboards een lage adoptiegraad, blijft de traditionele manier van werken in silo-omgevingen bestaan en sluimert de potentiële groei door datagestuurde inzichten. Klinkt dit bekend? Maar hoe krijg je een succesvol dashboard?

Veelvoorkomende fouten bij het succesvol maken van dashboards

Suboptimale interne ondersteuning:

- Doelen stellen: Een onduidelijke, ongestructureerde of onvolledige start van een dashboardproject resulteert in onjuiste dashboardvereisten. Het stellen van de juiste vragen en het verzamelen van de benodigde mensen is doorslaggevend bij het stellen van de juiste doelen. Als je dit niet doet, ontstaat er onduidelijkheid en levert het dashboard niet de beoogde inzichten op.

- Regels stellen: Het niet stellen van duidelijke regels met betrekking tot rollen, verantwoordelijkheden en de manier van werken kan ook leiden tot onduidelijkheid en een inefficiënt gebruik van middelen. Een van de meest onderschatte verantwoordelijkheden is het valideren van resultaten.

Inefficiënties in het dashboard:

- Interpretatie van gegevens: bij het ontwikkelen van een dashboard moet de focus niet liggen op fantasierijke of complexe manieren om je gegevens te visualiseren, maar op het gebruiken van de beste visualisaties om het verhaal binnen jouw gegevens te vertellen. Inzichten moeten snel en chronologisch worden weergegeven op de meest duidelijke manier mogelijk.

- Ontwerp: hoewel het verleidelijk kan zijn om felle kleuren, meerdere lettertypen of flitsende beelden te gebruiken, gaat dit allemaal ten koste van het doel van een dashboard: het tonen van de objectieve boodschap die gegevens kunnen onthullen. Inefficiënt en inconsistent gebruik van lay-out of positionering binnen of tussen dashboards kan jouw dataverhaal schaden.

- Dashboardvereisten: een veelvoorkomende valkuil is het uit het oog verliezen van vereisten bij het bouwen van een dashboard. Het is belangrijk om altijd rekening te houden met de doelgroep en het doel tijdens de ontwikkeling van het dashboard.

Gebrek aan gebruikersbetrokkenheid:

- Betrokkenheid van gebruikers: Gebruikers worden vaak vroeg in het proces betrokken, maar blijven buiten beschouwing totdat het eindproduct is opgeleverd. Deze lange periode zonder feedback kan leiden tot rapporten die niet voldoen aan de behoeften van de gebruiker, waardoor de bereidheid om een nieuw dashboard te adopteren afneemt.

- Technische ontwikkeling: Gebruikers vinden nieuwe tools zoals Power BI misschien afschrikwekkend en houden liever vast aan vertrouwde tools zoals Excel, uit angst voor taakautomatisering.

Vereisten voor succes van het dashboard

De veelvoorkomende valkuilen; suboptimale interne ondersteuning en dashboardinefficiënties, kunnen structureel worden aangepakt. Ze vereisen een focus op het ware doel van jouw dashboard, waardoor het dashboard zowel optimaal functioneel is als aansluit op de behoeften van jouw organisatie.

Ondersteuning en stakeholdermanagement

Voldoende interne ondersteuning tijdens zowel de ontwikkeling als het voortdurende gebruik van de dashboards is cruciaal. Dit begint met een diepgaand begrip van het doel van het dashboard en de eindgebruikers. Wat willen ze zien en, nog belangrijker, hoe willen ze het zien? Dit begrip vormt de basis van het ontwerp van jouw dashboard en heeft direct invloed op hoe gemakkelijk de gegevens kunnen worden geïnterpreteerd. Regelmatige betrokkenheid bij gebruikers zorgt ervoor dat het dashboard blijft voldoen aan hun behoeften en een logisch en samenhangend verhaal vertelt. Vergeet niet dat wat voor een ontwikkelaar vanzelfsprekend lijkt, niet altijd duidelijk is voor eindgebruikers.

Laten we praktisch worden: wat kan er gedaan worden om de essentie van het dashboard te bereiken? Maak kennis met ons BI Canvas. Deze tool omvat alle essentiële componenten die de effectiviteit en acceptatie van jouw dashboard bepalen. Zie het als de blauwdruk voor jouw dashboard. Door elk component zorgvuldig in te vullen, zorg je ervoor dat je het juiste verhaal vertelt, aan het juiste publiek, op de juiste manier. Door deze methode te gebruiken, kan je systematisch de belangrijkste gebieden van dashboardontwikkeling aanpakken, zodat jouw dashboards niet alleen functioneel zijn, maar ook inzichtelijk en breed geaccepteerd.

Data storytelling

Het ontwerp van jouw dashboard is cruciaal om gegevens er overzichtelijk uit te laten zien. Bovendien kan het belang van het zo eenvoudig en snel mogelijk verteerbaar maken van jouw gegevens niet genoeg worden benadrukt. De essentie is om de boodschap te tonen die verborgen zit in je gegevens die het antwoord bevat op de behoeften van uw organisatie en daarom moet de focus liggen op die twee dingen; jouw verhaal en de zakelijke vereisten. Een dashboard moet die boodschap zo duidelijk en snel mogelijk communiceren.

Er zijn veel manieren waarop het verhaal in jouw gegevens kan worden overgebracht door een dashboard. Dit kan worden gedaan door veranderingen in de huidige structuur van jouw dashboard en de manier van werken van dashboardontwikkeling te verstoren, of door veel kleine aanpassingen die je verhaallijn in zijn geheel verbeteren. Door te focussen op visueel ontwerp, filtering, context, duidelijke vereisten en framing, kunnen de gegevens in het dashboard worden omgezet in inzichten!

Benieuwd wat het BI Canvas inhoudt of hoe je data storytelling kunt verbeteren? Blijf op de hoogte voor een update in de nabije toekomst!

Welkom artificiële intelligentie

In dit interview spreekt Jonathan Aardema met prof. Eric Postma (hoogleraar Cognitive Science and Artificial Intelligence aan de Universiteit van Tilburg) over het waarom, hoe en wat van artificial intelligence applicaties. Wat zien we in de praktijk en wat zegt de wetenschap erover?

Gartner Magic Quadrant for Business Intelligence Platforms and Analytics 2020

Het Gartner Magic Quadrant for Business Intelligence is een analistenrapport waar we elk jaar naar uitkijken. Zowel de diepte als de reikwijdte van dit onderzoek maken het de moeite waard om te lezen. Maar niet veel mensen nemen de tijd om echt in de details van het rapport te graven.

Klantverloop verminderen door gebruik van data science

Het verminderen van klantverloop (customer churn) is één van de topprioriteiten van bedrijven. Nu hoor ik je denken: wat hebben data science en machine learning hiermee te maken? In deze blog vertellen we je hoe je klantverloop kunt verminderen met behulp van data science.

Data optimaal benutten met DBT

Binnen bedrijven is het beheersen van de kunst van het transformeren van data in bruikbare inzichten iets wat leiders onderscheidt van volgers. Bent je ooit in een situatie geweest waarin je twijfelde aan de betrouwbaarheid van jouw gegevens, wat leidde tot het niet nemen van beslissingen of de verkeerde beslissing? Lees dan deze blog!

DBT (data build tool) fungeert als een transformerende bondgenoot en geeft bedrijven niet alleen toegang tot, maar ook vertrouwen in hun data voor strategische besluitvorming. Laten we eens kijken naar de essentie van dbt en hoe het dient als katalysator voor datagestuurde besluitvorming, het verbeteren van de data-integriteit en het optimaliseren van de bedrijfsvoering.

Introductie van dbt

Stel je dbt voor als de brug die onbewerkte gegevens veilig over onzekerheid heen brengt naar informatie die gereed is voor analyse. Het is ontworpen om gegevens die in magazijnen zijn opgeslagen te verfijnen tot een schoon, betrouwbaar formaat, waardoor bedrijven met zekerheid en precisie strategische inzichten kunnen ontsluiten. Meer weten over de dbt-technologie? Neem eens een kijkje op onze technologiepagina!

Het versterken van strategische beslissingen

DBT is de basis voor het transformeren van onverwerkte gegevens in een betrouwbaar formaten voor besluitvormers. Hierdoor kunnen bedrijven de strategische planning met een hoog vertrouwen benaderen. Het kennen van hun acties wordt geïnformeerd door robuuste, betrouwbare data-inzichten.

Verhogen van datakwaliteit en vertrouwen

In de snel veranderende stroom van het hedendaagse zakelijke landschap kan de waarde van datakwaliteit en betrouwbaarheid niet genoeg worden benadrukt. DBT pakt deze uitdaging direct aan en implementeert nauwgezette test- en validatieprotocollen om de nauwkeurigheid van de gegevens te garanderen. Deze cruciale stap cultiveert een diep vertrouwen in datagestuurde inzichten die essentieel zijn voor geïnformeerde besluitvorming.

Stroomlijnen van operaties

Een opvallend kenmerk van DBT is het vermogen om het datatransformatieproces te automatiseren. Deze automatisering minimaliseert niet alleen de handmatige arbeid en de kans op menselijke fouten, maar verbetert ook de operationele efficiëntie. Door complexe dataworkflows te vereenvoudigen, kunnen bedrijven meer energie besteden aan hun kerndoelstellingen, waarbij inzichtelijke data worden ingezet voor groei en efficiëntie.

Een voorbeeld

Neem een hypothetische financiële dienstverlener die dbt gebruikt om transactiegegevens uit diverse systemen samen te voegen. Door de robuuste testmogelijkheden van dbt kan het bedrijf de precisie en betrouwbaarheid van zijn gegevens garanderen, waardoor nauwkeurige fraudedetectie en geïnformeerde kredietrisicobeoordelingen mogelijk worden. Deze casus onderstreept hoe dbt de bedrijfsvoering kan verfijnen en het vertrouwen van klanten kan versterken.

De voordelen van dbt

- Vertrouwen in data: Rigoureuze validatie zorgt voor een betrouwbare basis voor kritische bedrijfsstrategieën.

- Operationele stroomlijning: Automatisering vermindert handmatige taken en fouten, waardoor de procesefficiëntie wordt verhoogd.

- Versnelde inzichten: het gestroomlijnde proces van DBT bevordert snellere overgangen van gegevens naar beslissingen, waardoor flexibele reacties op de marktdynamiek mogelijk worden.

- Verbeterd gegevensbeheer: Geautomatiseerde documentatie en duidelijke lijnen verbeteren het beheer en zorgen voor naleving en transparantie.

- Schaalbare flexibiliteit: Met ondersteuning voor verschillende datawarehouses en een codegerichte aanpak is dbt gebouwd om met jouw bedrijf mee te groeien en zich aan te passen aan veranderende behoeften.

Samenvattend onderscheidt dbt zich als een belangrijk instrument in de moderne datastack, waardoor bedrijven de middelen krijgen om ruwe data efficiënt om te zetten in bruikbare inzichten. Door de nadruk te leggen op data-integriteit, betrouwbaarheid en operationele efficiëntie is dbt onmisbaar voor elke datagestuurde strategie, waardoor bedrijven met vertrouwen en strategische inzichten door de complexiteit van het zakelijke ecosysteem kunnen navigeren.

Dit is wellicht ook interessant voor je!

Datagedreven management informatie: De visie van Hans Platschorre

De Hans Anders Retail Group wil aanzienlijk uitbreiden naar het buitenland. De retailer is ook ambitieus in zijn informatiebehoeften. Wat is de impact van gegevensgestuurde rapporten? En wat betekent de digitale transformatie voor de toekomst van financiën? Martijn Meuling praat met CFO Hans Platschorre.

Datagedreven inzichten met dashboards bij ADO Den Haag

ADO Den Haag is als voetbalclub bekend om haar groen/gele kleuren en de kenmerkende ooievaar. Wat veel mensen echter niet weten, is dat ADO Den Haag achter de schermen een heuse datatransformatie ondergaat. De club krijgt door middel van data nog meer inzicht in haar performance, zodat zij beter kan anticiperen en sturen. De eerste stap is het automatiseren van handmatige overzichten en het creëren van dashboards in Power BI.

API’s ontsluiten; hoe moeilijk kan het zijn?

Spoiler alert: het kan heel moeilijk zijn....

Het bouwen van een datagedreven oplossing begint met het ontsluiten van data uit uw systemen. Voor veel cloudapplicaties vereist dit het gebruik van API’s. In deze blog leggen we de basisprincipes van API's uit, hoe API's ontsluiten werkt, en hun uitdagingen en delen we eenvoudig te gebruiken tools om je op weg te helpen en jouw datagedreven reis een vliegende start te geven.

Basisprincipes van API’s

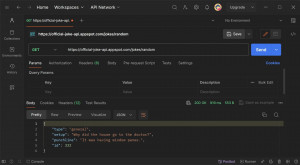

In de kern is een API (Application Programming Interface) een set regels die communicatie tussen verschillende softwareapplicaties mogelijk maakt. Het fungeert als een brug waardoor applicaties gegevens kunnen uitwisselen. Een API werkt als een messenger; het neemt verzoeken aan, vertelt een systeem wat je wilt doen en retourneert vervolgens het antwoord van het systeem. Om het in actie te zien, kopieert en plak de volgende link in je browser:

https://official-joke-api.appspot.com/jokes/programming/random

Wanneer je op ‘Enter’ drukt, wordt er een verzoek verzonden en op basis van de API-regels ontvang je als reactie een willekeurige programmeergrap, zoals deze: [{“type”programming”, “setup” “Hoeveel weegt een hipster?”,”punchline:Een Instagram.”,”id”:146}] Het antwoord is in JSON-formaat (JavaScript Object Notation), dat doorgaans door de meeste API’s wordt gebruikt. Deze JSON kan worden geformatteerd om hem leesbaarder te maken (er zijn ook opmerkingen opgenomen om de JSON-syntaxis uit te leggen)

[ <-- start table

{ <-- start row

"type": "programming", <-- kolom: value

"setup": "How much does a hipster weigh?",

"punchline": "An Instagram.",

"id": 146

} <-- end row

] <-- end table

The same data In table format:

| type | setup | punchline | id |

|---|---|---|---|

| general | How much does a hipster weigh? | An Instagram. | 146 |

Gefeliciteerd! Je hebt je eerste stappen gezet in de wereld van API’s. Hoewel dit voorbeeld eenvoudig was, is het de moeite waard om op te merken dat niet alle API’s zo eenvoudig zijn.

Uitdagingen bij het werken met API’s

Verbinding maken met een API kan een krachtige manier zijn om toegang te krijgen tot gegevens, maar brengt ook een unieke reeks uitdagingen met zich mee. Hier zijn enkele veelvoorkomende uitdagingen:

1. Authenticatie:

Het tot stand brengen van veilige toegang tot API’s kan lastig zijn. Veel API’s vereisen authenticatie om ervoor te zorgen dat alleen geautoriseerde gebruikers of applicaties toegang hebben tot hun gegevens. Authenticatiemethoden, waaronder API-sleutels, OAuth-tokens of andere aangepaste authenticatiemechanismen, kunnen variëren. Het kan een uitdaging zijn om de specifieke authenticatiemethode te begrijpen en deze correct te implementeren. Onjuiste implementatie leidt tot de beruchte fout “401 Unauthorized”.

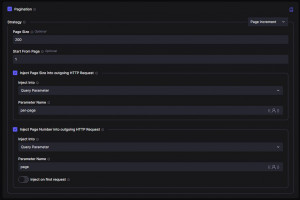

2. Paginering:

Om prestatieredenen beperken API’s vaak de gegevens die in elk antwoord worden geretourneerd. Daarom wordt een significant antwoord opgesplitst in kleinere pagina’s. Het bouwen van logica om door de pagina’s te bladeren totdat alle gegevens zijn opgehaald, kan lastig zijn. Een veel voorkomende fout, ‘404 Not Found’, kan optreden bij het openen van een niet-bestaande pagina.

3. Data limieten:

API’s leggen vaak gebruikslimieten op binnen specifieke termijnen om zichzelf en de onderliggende systemen te beschermen. Als deze limieten worden overschreden, wordt de foutcode ‘429 Too Many Requests’ geactiveerd als beschermende maatregel.

4. Documentatie:

API-documentatie fungeert als je bondgenoot tijdens het API-integratietraject. In de documentatie kan je de verzoeken, authenticatiemethoden, pagineringsrichtlijnen en eventuele beperkingen van de API ontdekken.

Hoewel deze uitdagingen misschien overweldigend lijken, zijn er tools beschikbaar om de verbindingsconfiguratie te vereenvoudigen en de meeste hindernissen te overwinnen.

Tools voor het ontsluiten van gegevens uit API’s

Talloze tools kunnen hetzelfde trucje uitvoeren: gegevens verbinden en extraheren uit een API en deze op een veilige plek opslaan, vaak een database. We zullen de tools onder de aandacht brengen die vaak bij Rockfeather worden gebruikt, elk met zijn eigen unieke sterke punten en mogelijkheden; het is het vermelden waard dat er veel alternatieven bestaan.

1. Postman

Postman is een veelzijdige API-testtool die voornamelijk gericht is op het debuggen en maken van API’s. Het is gebruiksvriendelijk en heeft veel functies om je op weg te helpen met een verbinding met een API. Hoewel de sterke punten liggen in onderzoek en begrip, is het belangrijk om te weten dat Postman gegevens niet automatisch in een database kan opslaan

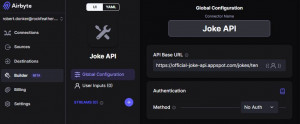

2. Airbyte

Airbyte is een open-sourceplatform voor data-integratie. Het biedt een interface zonder code. Met meer dan 350 vooraf gebouwde dataconnectoren biedt het een eenvoudig maar robuust startpunt dat naadloos meegroeit met je groeiende databehoefte.

Een opvallend kenmerk van Airbyte is de ondersteuning voor aangepaste connectoren. Airbyte bied een unieke low-code interface als je een aangepaste connector moet bouwen. Deze interface wordt geleverd met ingebouwde functies voor authenticatie en paginering – functies die Airbyte onderscheiden, aangezien veel andere tools dergelijke functionaliteiten niet hebben.

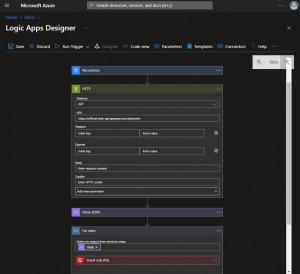

3. Azure Logic Apps

Azure Logic Apps is een cloudgebaseerde service voor het bouwen van geautomatiseerde workflows via een gebruiksvriendelijke visuele ontwerpinterface, waardoor deze zelfs toegankelijk is voor mensen zonder uitgebreide kennis van coderen. Met 450 vooraf gebouwde dataconnectoren en een uitgebreide toolkit voor aangepaste connectoren onderscheidt Azure Logic Apps zich als een flexibele en universele tool. De goede plek wordt waargenomen bij het omgaan met complexere API’s met lagere datavolumes.

Naast gegevensintegratie blinkt Azure Logic Apps uit in taakautomatisering voor het verzenden van e-mails, waarschuwingen, enquêtes, goedkeuringen en systeemintegraties om gegevens tussen systemen te verplaatsen. Bijvoorbeeld om klantinformatie te synchroniseren tussen een ERP- en CRM-systeem.

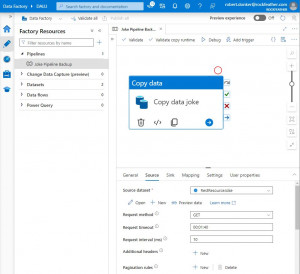

4. Azure Data Factory

Azure Data Factory is een cloudgebaseerde dienst voor het aanleggen van pijpleidingen. Het heeft een Low-code-interface met vooraf gedefinieerde bouwstenen. Presteert het beste bij het verplaatsen van grote hoeveelheden gegevens uit een database of een van de andere 80+ connectoren. Voor aangepaste verbindingen is het echter minder ideaal.

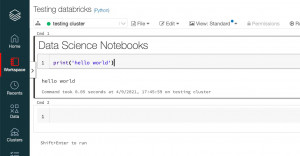

5. Databricks

Databricks is een cloudgebaseerd platform voor het verwerken van big data en machine learning-workloads. Het platform biedt de flexibiliteit om notebooks te maken en uit te voeren. Door Python-code te schrijven, kan je verbinding maken met elke beschikbare gegevensbron en bestaande Python-pakketten benutten. Het is echter belangrijk op te merken dat Databricks, hoewel krachtig, een diepere codeerkennis vereist om de uitgebreide platformmogelijkheden volledig te ontsluiten.

Conclusie

Kortom, deze tools bieden diverse benaderingen voor het extraheren van gegevens uit API’s, waarbij rekening wordt gehouden met verschillende voorkeuren, vaardigheidsniveaus, zakelijke vereisten en gegevensbronnen. Het is vermeldenswaard dat een combinatie van hulpmiddelen effectiever kan zijn voor jouw specifieke behoeften. Azure Logic Apps en Azure Data Factory zijn een veel voorkomende en krachtige combinatie die vaak wordt gebruikt.

Het starten van jouw datatraject en het verbinden met API’s is een uitdaging, vooral voor beginners. Ondanks de hindernissen zijn er hulpmiddelen om je te helpen. De sleutel is om die eerste stap te zetten.

Wil je meer weten over de tools die we gebruiken bij Rockfeather? Sluit aan bij de Data & Automation Line Up op 16 mei. Laten we het proces vereenvoudigen en samen de wereld van data verkennen.

Dit is wellicht ook interessant voor je!

Datagedreven inzichten met dashboards bij ADO Den Haag

ADO Den Haag is als voetbalclub bekend om haar groen/gele kleuren en de kenmerkende ooievaar. Wat veel mensen echter niet weten, is dat ADO Den Haag achter de schermen een heuse datatransformatie ondergaat. De club krijgt door middel van data nog meer inzicht in haar performance, zodat zij beter kan anticiperen en sturen. De eerste stap is het automatiseren van handmatige overzichten en het creëren van dashboards in Power BI.

Datagedreven plannen bij ProRail

In 2030 wil ProRail 30% meer capaciteit hebben voor het laten rijden van treinen. Dat vraagt nogal wat van de organisatie, en van de besturing. Datagedreven inzichten zijn dan ook onontbeerlijk. Dashboards in Microsoft Power BI geven realtime informatie over de prestaties, de trends en de gevolgen voor de planning van spoorwerkzaamheden. Dit verbetert de procesgerichte en datagedreven besluitvorming, zodat ProRail invulling kan geven aan de forse groeiambitie.

Hoe breng je jouw Data Science project tot leven?

Termen als data science, machine learning en AI worden steeds vaker gezien en gehoord. Toen de AI-tekstgeneratietool ChatGPT werd uitgebracht, werd het al snel de snelstgroeiende applicatie ooit. Het kostte de tool van OpenAI slechts 5 dagen om 1 miljoen gebruikers te bereiken. Om dat in perspectief te plaatsen: het kostte Facebook 10 maanden en Twitter 2 jaar!

Waar data science al jaren een spannend onderwerp is voor de meer technisch onderlegde mensen, heeft AI eindelijk het grote publiek aanzienlijk bereikt. Deze nieuwe golf van AI-populariteit heeft de belangstelling van het bedrijfsleven aangewakkerd om meer te leren over Data Science, AI en de mogelijkheden ervan. Met deze blog geven we je informatie die je kan helpen je eerste data science-project een vliegende start te geven, zodat deze buzz woorden werkelijkheid worden voor jouw organisatie.

Wat is Data Science?

Voordat we ingaan op wat je met data science kunt doen en hoe je een project moet aanpakken, bespreken we eerst kort wat data science is.

Data science is het proces waarbij kennis en inzichten uit ruwe data worden gehaald. Het bedrijf kan deze informatie vervolgens gebruiken om de besluitvorming te versterken en goed geïnformeerde actie te ondernemen. Data Science is in wezen het proces waarbij waarde uit je gegevens wordt gehaald. Data Science combineert wiskunde en statistiek, informatica en domeinexpertise. Data Science kent veel verschillende manieren om gegevens te verwerken en waardevol te maken. Deze omvatten datavisualisatie, statistische analyses, text mining, outlier detectie, machine learning, computer vision en nog veel meer.

Waarom zou je beginnen met Data Science?

De International Data Corporation (IDC) voorspelde in 2017 dat de hoeveelheid data die wordt geanalyseerd exponentieel zou groeien en binnen acht jaar met een factor 50 zou toenemen. We hebben nu enkele metingen tot ongeveer 2022, en de groei die IDC in 2017 voorspelde, was correct. Er worden steeds meer data gegenereerd. En dit is interessant voor de data scientist. Zoals hierboven besproken, kunnen gegevens waardevol zijn als we deze slim en effectief gebruiken.

Data Science vormt de kern van het begrijpen van de enorme hoeveelheden gegevens die we dagelijks genereren, en zet deze om in bruikbare inzichten die de besluitvorming kunnen verbeteren, de klantervaring kunnen verbeteren en zelfs kritieke problemen kunnen oplossen. Het is een superkracht in de huidige datagestuurde wereld, en als je dit begrijpt, rust je jezelf uit met de kennis om echt een verschil te maken.

Data Science begint een revolutie teweeg te brengen in meerdere wetenschapsgebieden. Om een paar voorbeelden te noemen: op medisch gebied heeft AI geholpen bij het vouwen van eiwitten en bij het sneller en nauwkeuriger opsporen van kanker. Extreme weersomstandigheden, zoals tornado’s, kunnen eerder door AI-systemen worden voorspeld dan voorheen mogelijk was. En in de toekomst zullen zelfrijdende auto’s de wegen voor iedereen veiliger maken.

Voor bedrijven kan Data Science echter ook impact hebben. Uit onderzoek van Forrester (2020), een wereldwijd marktonderzoeksbureau, bleek dat datagestuurde bedrijven 58% meer kans hadden om hun omzetdoelstellingen te behalen dan hun niet-datagestuurde branchegenoten. De adoptie van data science in jouw bedrijf kan een echte impact hebben.

Wat kun je met Data Science?

De mogelijkheden van data science zijn vrijwel onbeperkt en raken vrijwel elke denkbare sector. Afhankelijk van de (soort) beschikbare data en het gestelde doel voor het project wordt gekozen voor een specifieke data science aanpak. Enkele voorbeelden van wat mogelijk is met data science:

Verbetering van de klantervaring

Data Science kan de klantervaring aanzienlijk verbeteren door interacties te personaliseren op basis van klantgegevens. Detailhandelaren kunnen bijvoorbeeld data science gebruiken om producten aan klanten aan te bevelen op basis van hun browse- en aankoopgeschiedenis. Dit verhoogt niet alleen de klanttevredenheid, maar verhoogt ook de omzet.

Optimaliseren van operaties

Via voorspellende analyses en machine learning-modellen kunnen bedrijven de vraag voorspellen, de voorraad efficiënter beheren en de bedrijfsvoering stroomlijnen. Deze optimalisatie kan leiden tot kostenbesparingen en een verbeterde klantenservice door ervoor te zorgen dat producten en diensten betrouwbaarder en efficiënter worden geleverd.

Fraudedetectie en risicobeheer

Financiële instellingen maken gebruik van data science om frauduleuze transacties in realtime te detecteren, waardoor de verliezen aanzienlijk worden verminderd. Op dezelfde manier kunnen verzekeringsmaatschappijen het gebruiken om risico’s nauwkeuriger in te schatten, door premies vast te stellen die beter aansluiten bij het werkelijke risico dat het verzekeren van een persoon of bedrijf met zich meebrengt.

Geïnformeerde beslissingen nemen

Data Science stelt bedrijven in staat beslissingen te nemen op basis van data in plaats van op basis van intuïtie. Door trends en patronen te analyseren, kunnen bedrijven nieuwe marktkansen identificeren, de voorkeuren van klanten begrijpen en sneller reageren op veranderingen in de markt. En dit is nog maar een kleine greep uit de mogelijkheden van data science use cases!

Hoe kun je aan de slag met Data Science?

Het starten van jouw eerste data science-project kan een grote taak lijken. Om je hierbij te helpen, volgen hier enkele stappen die we graag volgen tijdens het uitvoeren van een project.

Bepaal je doel

Begin met het duidelijk definiëren van het doel van jouw project. Denk na over wat we proberen te doen en waarom we dat doen. Denk ook na over wie we proberen te helpen en betrek hen bij het stellen van doelen. Een specifiek doel zal je helpen jouw inspanningen te sturen en je in staat te stellen jouw succes te meten.

Verzamel en bereid je gegevens voor

Begin met het verzamelen van gegevens die kunnen worden gebruikt voor het doel dat je stelt. Dit kunnen gegevens zijn die intern beschikbaar zijn, zoals gegevens over financiën, bedrijfsvoering of klanten. Of gegevens uit externe bronnen zoals weergegevens, gegevens over de wereldmarkten of informatie die van websites is gehaald. Bedenk ook welke gegevens nu niet direct beschikbaar zijn, maar wel waardevol kunnen zijn, en begin met het verzamelen van deze gegevens.

Nadat we onze gegevens hebben verzameld, kunnen we onze gegevens voorbereiden op de volgende stappen. Dit kan het opschonen van de gegevens inhouden, het omgaan met ontbrekende waarden en het transformeren van variabelen.

Verkennende gegevensanalyse (EDA)

Voordat je in complexe Data Science benaderingen duikt, voer je EDA uit om inzicht te krijgen in jouw gegevens, de patronen, afwijkingen of spannende relaties ervan. Deze kennis zal je helpen bij de volgende stappen.

Kies de juiste tools en technieken

Afhankelijk van het doel van jouw project selecteer je de juiste data science-aanpak en -tool(s). Zoals hierboven besproken, biedt data science veel manieren om waarde uit jouw gegevens te halen. Dit kan variëren van regressieanalyse voor het voorspellen van numerieke waarden tot clustertechnieken voor segmentatietaken of statistische analyse. De juiste aanpak is afhankelijk van het gestelde doel en de beschikbare data. Doe hier wat onderzoek; er is vaak een eenvoudige en effectieve manier om je doel te bereiken.

Bedenk ook in welke tool je wilt werken. Wil je een eenvoudige tool zonder (veel) codering of een tool die je veel geavanceerde mogelijkheden geeft? Moet de tool cloudgebaseerd zijn of lokaal worden uitgevoerd? Als je al over een solide data-infrastructuur beschikt, overweeg dan de compatibiliteit met jouw huidige systeem. Het kiezen van het juiste gereedschap is afhankelijk van de situatie en het project. Wil je inspiratie over hoe je deze interne kennis naar een hoger niveau krijgt? Lees hier hoe Greenchoice haar kennis van Data Science heeft vergroot

Evalueer en herhaal

Na het uitvoeren van jouw data science-project evalueer je de prestaties ervan met behulp van de juiste statistieken. Gebruik de doelen die in het begin zijn gesteld en beoordeel of deze met de huidige resultaten kunnen worden bereikt. Wees bereid om jouw model te herhalen op basis van feedback en resultaten om de nauwkeurigheid ervan te verbeteren.

Operationaliseren

Nadat we het data science project hebben uitgevoerd en tevreden zijn met de resultaten, willen we de uitkomsten gaan gebruiken binnen onze organisatie. Het proces van het operationeel maken van jouw data science-oplossing kan variëren van eenvoudig tot meer geavanceerd en is wederom afhankelijk van het type aanpak, de gebruikte tool en hoe de oplossing zal worden gebruikt. Daarom is het betrekken van de eindgebruiker bij het stellen van doelen erg belangrijk.

Conclusie

Data Science kan een krachtig hulpmiddel zijn als het effectief wordt gebruikt, waardoor jouw bedrijf een voordeel krijgt. Hopelijk heb je iets geleerd over data science en wat dit voor jouw bedrijf kan betekenen, en weet je hoe je jouw data science project een vliegende start kunt geven! Heb je vragen of wil je brainstormen over hoe je data science binnen jouw bedrijf kunt gaan inzetten, neem dan contact met ons op! Ook kunnen wij je helpen bij de eerste stap bij het definiëren van de juiste use cases met behulp van onze templates en kennis.

Wil je geïnspireerd worden welke tools er op de markt beschikbaar zijn? Tijdens ons gratis online evenement genaamd de Data & Automation Line Up op 16 mei bespreken we de laatste ontwikkelingen rond data & automatiseringsoplossingen. De keuze is aan jou, van datavisualisatie tot data-engineering en van low-coding tot data science! Of je nu op zoek bent naar iets nieuws of meer uit jouw bestaande oplossing wilt halen. In één middag ben je up-to-date en zie je de nieuwste functionaliteiten en oplossingen live in actie.

Woon het hele programma bij of alleen de sessies die op dit moment voor jou relevant zijn. Het is aan jou! Meer informatie over het evenement? Bekijk hier het volledige programma.

Wellicht is dit ook interessant voor je

Data Science als volgende stap in datavolwassenheid - Greenchoice

Een ambitieuze data-strategie, toekomstbestendige data-architectuur én een snelgroeiend aantal eindgebruikers van de datavisualisatie-omgeving: er zijn al flinke stappen gezet door groene energieleverancier Greenchoice. Om de volgende stap te zetten naar datavolwassenheid heeft Greenchoice in samenwerking met Rockfeather een in-company Data Science training ontwikkeld. Hoofddoel van deze training: Data Science use cases identificeren, ontwikkelen en uitvoeren. Alex Janssen, Manager Development Consument en Data & Analytics vertelt wat deze training heeft opgeleverd.

Minder opzeggingen van seizoenkaarten door machine learning bij ADO Den Haag

Voor voetbalclubs die uitkomen op het hoogste niveau zijn seizoenkaarten een van de belangrijkste inkomstenstromen. Een club heeft er dan ook baat bij om het aantal opzeggingen zo laag mogelijk te houden. Het is voor veel clubs echter moeilijk om in te schatten wie er nou precies weggaat. In deze casus laten wij zien hoe wij bij ADO Den Haag met een voorspellend model hebben gezorgd voor inzicht in mogelijke opzeggingen.

Waarom Power Apps een goede Excel vervanger is

In deze blog kijken we naar een scenario in de wereld van data wat we regelmatig terugzien: Microsoft Excel versus Power Apps. Power Apps biedt een geweldig alternatief voor onze traditionele spreadsheets. We onderzoeken waarom het wellicht een slim idee kan zijn om over te stappen van je vertrouwde spreadsheets naar een modern toolset als Power Apps.

Waar het ooit begon…

Excel is de grootvader van het beheren van data! We gebruiken het al heel lang om te helpen met berekeningen, het maken van grafieken en allerlei andere soorten datawerk. We hebben veel begrotingen gemaakt, uitgaven bijgehouden en zelfs draaitabellen onder de knie gekregen met behulp van Excel. Maar de hoeveelheid gegevens die we gebruiken groeit en bedrijfsprocessen worden complexer. Kortom, het is tijd om te kijken naar nieuwere, flexibelere oplossingen.

Eerst kijken we naar de voor- en nadelen van good-old Excel:

Microsoft Excel blinkt uit door zijn veelzijdigheid en robuuste tools voor gegevensvisualisatie, waardoor het een veelgebruikt programma is voor alles van eenvoudige sommen tot mooie grafieken die trends verduidelijken. Zeg nou zelf: wie is er niet begonnen met het bijhouden van zijn persoonlijke financiële budget in Excel 🤑? Iedereen toch? Maar – zoals je misschien al hebt gemerkt – is Excel niet perfect. Je levert behoorlijk in op snelheid wanneer je met grote hoeveelheden data aan de slag gaat. En als er te veel handen in dezelfde spreadsheet zitten, kan het risico op verwisselingen en fouten de zaken rommelig maken. Om nog niet te spreken over versiebeheer. Excel is het perfecte manusje-van-alles, maar krijgt het lastig bij omvang en teamwork.

Dat is waar Power Apps om de hoek komt kijken, Microsofts antwoord op rommelige samenwerkingen en spreadsheets. Power Apps is een low-code platform dat je kunt zien als een combinatie van PowerPoint en Excel. Het heeft de logica en rekenkracht van Excel en de WYSIWYG (What-You-See-Is-What-You-Get) ontwerpervaring van PowerPoint. Je kunt er aangepaste toepassingen mee maken (desktop, tablet en telefoon!) zonder dat je veel programmeervaardigheden nodig hebt. Dus, combineer het met een geschikte databaseoplossing en je kunt het zien als het frisse, flexibelere en krachtigere broertje of zusje van Excel, klaar om ingewikkeldere taken gemakkelijk aan te kunnen. Laten we eens kijken naar de voor- en nadelen:

Voordelen van Microsoft Power Apps:

- Snelle App Development: Met Microsoft Power Apps ontwikkel je snel toepassingen met een low-code of no-code aanpak. PowerFX, de code die je schrijft in Excel, gebruik je ook om logica te schrijven in Power Apps. Dit betekent dat mensen met verschillende technische vaardigheden gemakkelijk aangepaste apps kunnen maken, waardoor ze tijd en middelen besparen tijdens het ontwikkelingsproces.

- Naadloze integratie in het Microsoft Ecosysteem: Microsoft Power Apps sluit naadloos aan op andere Microsoft 365- en Azure-services en creëert zo een uniforme omgeving voor app-ontwikkeling. Deze integratie stroomlijnt data connectiviteit, samenwerking en het gebruik van extra functionaliteiten binnen het bredere Microsoft-ecosysteem.

- Gecentraliseerde Datainvoer & opslag: PowerApps biedt een beter georganiseerd en betrouwbaarder gegevensbeheersysteem in vergelijking met Excel door één centraal formulier voor gegevensinvoer te bieden, waardoor fouten bij versiebeheer en gegevenscorruptie worden verminderd. Door middel van deze centrale manier van gegevensinvoer zorg je voor een veiligere en foutloze omgeving voor gegevens, waardoor de integriteit en betrouwbaarheid worden verbeterd.

Nadelen van Microsoft Power Apps:

- Leercurve voor geavanceerde features: Hoewel Power Apps ontwerpen is met gebruiksvriendelijkheid als een van de speerpunten, kan het beheersen van de grote diversiteit aan geavanceerde toepassingen een stijle leercurve vormen voor gebruikers met beperkte technische ervaring.

- Budget overwegingen: De kosten voor het gebruik van Power Apps kunnen oplopen, afhankelijk van de schaal en complexiteit van de applicaties. Organisaties doen er goed aan hun behoeften te evaluaren om zo het juiste licentieniveau te bepalen. Er wordt namelijk onderscheid gemaakt in prijs bij het gebruik van premium functionaliteiten.

Samenvattend: Power Apps versus Excel?

Waar Excel uitblinkt in eenvoudige taken, is Power Apps de oplossing voor complexere, dynamische uitdagingen. Excel volledig vervangen is dan ook niet aan de orde, maar de aanvulling met Power Apps zorgt voor schaalbare, app-gebaseerde oplossingen. Deze verschuiving vergroot je gereedschapskist, maakt je efficiënter en stelt je in staat om datagestuurde beslissingen te nemen. Overweeg Power Apps om makkelijk-te-gebruiken applicaties te maken voor je collega’s, op basis van een robuuste database. Daarnaast kun je Excel blijven gebruiken voor eenvoudige, individuele taken. Deze oplossingen complimenterend aan elkaar inzetten zorgt voor efficiënt en innovatief gegevensbeheer.

Benieuwd naar meer?

Deze pagina gaat volledig over Microsoft Power Apps en bevat een korte demovideo. Bekijk ook eens onze agenda, we houden regelmatig webinars of evenementen rondom dit onderwerp.

Welkom artificiële intelligentie

In dit interview spreekt Jonathan Aardema met prof. Eric Postma (hoogleraar Cognitive Science and Artificial Intelligence aan de Universiteit van Tilburg) over het waarom, hoe en wat van artificial intelligence applicaties. Wat zien we in de praktijk en wat zegt de wetenschap erover?

Gartner Magic Quadrant for Business Intelligence Platforms and Analytics 2020

Het Gartner Magic Quadrant for Business Intelligence is een analistenrapport waar we elk jaar naar uitkijken. Zowel de diepte als de reikwijdte van dit onderzoek maken het de moeite waard om te lezen. Maar niet veel mensen nemen de tijd om echt in de details van het rapport te graven.

Klantverloop verminderen door gebruik van data science

Het verminderen van klantverloop (customer churn) is één van de topprioriteiten van bedrijven. Nu hoor ik je denken: wat hebben data science en machine learning hiermee te maken? In deze blog vertellen we je hoe je klantverloop kunt verminderen met behulp van data science.

- Alle oplossingen op een rij binnen de Azure Integration Services

- Automatiseren van Dataprocessen

- Integratie as a services vs analytics integraties

Wat is Microsoft Data Integration Services

In deze blog vertellen we je alles over Microsoft Data Integratie Services. De Microsoft Data Integratie Services is onder te verdelen in twee categorieën:

- On-premise, (lokale) variant. Hierbij werkt men lokaal op een server en ontwikkel je de integraties en workflows op deze server. Dit noemen we Sql Server Integration Services (SSIS)

- Azure Integration Services (AIS): Hierbij werkt men op het cloud platform van Micrsoft (Azure) en bestaat de Integratie service uit verschillende oplossingen welke tezamen de integratie oplossingen van Microsoft vormen. Deze set aan oplossingen samen heet de Microsoft Azure Integration Services.

In deze blog zullen wij ons alleen focussen op de verschillende oplossingen in binnen het AIS platform.

Wat doet Microsoft Azure Integration Services

AIS is voornamelijk bedoeld om data te verplaatsen en is een overkoepelende naam voor 5 oplossingen die zich hierbinnen bevinden. Hierbij kun je denken aan het overbrengen van data uit de verschillende systemen van een organisatie naar een data warehouse (data hub) omgeving. AIS heeft connectoren om verbindingen te leggen naar dergelijke systemen. De data die opgehaald kan worden, kan verschillende vormen hebben:

- Gestructureerde data (data in tabellen)

- Semi-gestructureerde data (e-mail, PDF, html)

- Ongestructureerde data (video en foto)

De verschillende oplossingen binnen AIS zijn in 2 toepassingsgebieden onder te verdelen; Integratie as a service en Analytics

Integratie as a service (IAAS)

IAAS kenmerkt zich door real time data verschuivingen tussen tal van systemen en is vaak het hart van een bedrijf. Denk hierbij aan een order die in een webapplicatie geplaatst wordt en doormiddel van een IPAAS (Integration Platform as a Service) verplaatst wordt naar het boekhoudpakket en een ordermanagement systeem bijvoorbeeld. Dit type data integratie is vaak near real time en event gebaseerd. Ook zijn veel van de integraties gebaseerd op API’s. De oplossingen in de Azure Integration Services die hiervoor gebruikt worden zijn oa Logic Apps, Service Bus, API Management en Event Grid

Analytics integratie

Bij analytics toepassingen worden verschillende systemen ontsloten en wordt deze data uit de verschillende bronnen weggeschreven in een data hub. Deze data kun je vervolgens gebruiken in tal van andere systemen. Denk bijvoorbeeld aan de rapportage tool PowerBI of Tableau. Waarbij het laden en prepareren van de data separaat gebeurt op een centrale omgeving. Hierdoor creëer je consistente resultaten welke hergebruikt kunnen worden. In dit geval wordt data (in tegenstelling tot IAAS) vaak batchgewijs geladen. Ook wordt er veel meer rechtstreeks geconnecteerd met bronsystemen en vinden data refreshes meestal gepland of getriggered plaats. De oplossingen in de Azure Integration Services die hiervoor gebruikt worden zijn oa Logic Apps, Azure Data Factory en Azure Analysis Services.

Hierbij een kort overzicht van deze verschillende oplossingen van beide domeinen en wat ze kunnen:

- Logic Apps: Met Logic Apps maak je overzichtelijke werkstromen (workflows) waarmee je connecteert naar verschillende systemen met behulp van APIs. Deze workflows worden in de vooraf definieerde volgorde uitgevoerd wanneer de trigger wordt geactiveerd.

- Service Bus: Azure Service Bus is een berichtenservice in de cloud die wordt gebruikt om alle toepassingen, apparaten en services die in de cloud worden uitgevoerd, te verbinden met andere toepassingen of services.

- API Management: Een hybride beheerplatform voor meerdere clouds voor API’s in alle omgevingen. Op deze manier kunnen interne en externe ontwikkelaars op ieder moment verbinding maken met de back-end systemen.

- Event Grid: Event Grid is een geïntegreerde service voor het beheer van de routering van alle gebeurtenissen, vanuit elke bron naar elke bestemming (wat gebeurd wanneer en waar moet op basis van de gebeurtenis de data heen).

- Azure Data Factory: Azure Data Factory is een cloudgebaseerde gegevensintegratieservice waarmee je datagedreven workflows in de cloud maakt en hierbij kun je gegevensverplaatsing en gegevenstransformatie automatiseren.

Voordelen van Microsoft Data Integration Services

- Centraal te beheren

- Consistente transformaties op de data

- Overzichtelijke om mee te werken door middel van process flows

- Ongekend veel connectoren om bronsystemen te ontsluiten

- Makkelijk om transformaties op de date te maken

Rockfeather & Microsoft Data Integration Services

Met Rockfeather gebruiken we deze oplossingen door een tussenlaag te creëren wanneer wij de data uit systemen ophalen. Of dit nu voor een IAAS vraag is of meer voor een Analytics vraag.

Wij ontsluiten bijvoorbeeld het ERP systeem, een HR-systeem en een tool met een API. Wij kunnen dit allemaal wegschrijven naar een datahub. Deze hun gebruiken wij vervolgens als bron voor de eerdergenoemde oplossingen. Het voordeel hiervan is dat we ongeacht de oplossing dezelfde resultaten kunnen inladen. Daarnaast is het efficiënt en overzichtelijk om de data op te halen en te transformeren waar nodig. Nadat we dit allemaal hebben neergezet blijft het ook volledig geautomatiseerd updaten.

Data & Analytics Line Up (terugkijken)

Ben jij op zoek naar een nieuwe dashboarding of dataintegratie-oplossing? Wil je datascience-oplossingen vergelijken? Of wil je Low Coding platforms in actie zien? Het kan allemaal tijdens de Data & Analytics Line Up 2021! De opnames zijn nu beschikbaar.

Geautomatiseerde rapporten met Power BI Report Builder

Dat er met Power BI dashboards gemaakt kunnen worden is inmiddels bij veel organisaties bekend. Wat veel mensen echter niet weten is dat er een tool binnen Power BI bestaat die uitkomst kan bieden als er specifiek vraag is naar (geautomatiseerde) PDF of Excel rapporten. Deze tool heet namelijk Power BI Report Builder. In dit artikel zullen we dieper ingaan op Power BI Report Builder zodat je een beter beeld krijgt van deze tool.

Row-level security in Power BI

Om ervoor te zorgen dat data in Power BI rapporten niet in de verkeerde handen valt is het mogelijk om Row-Level Security (RLS) toe te passen op elk rapport binnen een werkruimte. Dit zorgt ervoor dat per ontvanger van het rapport een verschil kan worden gemaakt in welke gegevens zij kunnen zien. Het is van belang dat de inrichting nauwkeurig wordt gedaan en dat de leden van een werkruimte de juiste rol toegewezen krijgen om te voorkomen dat zij bijvoorbeeld te veel informatie zien. Deze RLS inrichting van de online werkruimtes in Power BI is de laatste paar maanden veranderd. In dit blog leggen we uit waar je op moet letten bij het inrichten van een nieuwe werkruimte en het instellen van de vernieuwde row-level security in Power BI.